Fisher's Linear Discriminant (FDA, LDA, QDA)

一種監督式學習的機器學習模型,根據資料常態假設做的線性分類模型

引言

給定資料 (X,Y)∼i.i.d.PX,Y,其中 Y∈{1,2,⋯,K}=Y 是類別型的,根據貝氏定理

P(Y=k∣X=x)=∑u∈YP(X=x∣Y=u)P(Y=u)P(X=x∣Y=k)P(Y=k)左側的 P(Y=k∣X=x) 就是目標函數,用於描述 “給定 x 的條件下,Y 是第 k 類的機率”。

若 G(x) 是 Y 的預測函數,在 0-1 loss function L(Y,G(x))=I(Y=G(x)) 情況下,則「最小化 Bayes Risk 的 G」同時也是「最大化 P(Y=y∣X=x) 的解」

G(x)=G∈FargminEY∣xL(Y,G(x))=k∈YargmaxP(Y=k∣X=x)=k∈YargmaxP(X=x∣Y=k)P(Y=k)Fisher’s Linear Discriminant 是藉由分配假設,將資料視為 K 群 normal,藉此找到在給定 x 的條件下,能使 P(Y=k∣X=x) 最大化的 k。

模型假設

在 P(Y=k∣X=x) 的等式中有兩部分需要運算,分別是 P(Y=k) 與 P(X=x∣Y=k)。此時會假設

- P(Y=k)=πk

- X∣Y=k∼Np(μk,Σk)

對於 πk 通常直接採用第 k 類所佔比例直接估計且 ∑k∈Yπk=1。對於常態假設,理解為「不同群的 Y=k,其 X 分屬於不同群體的 normal 群體。」寫作

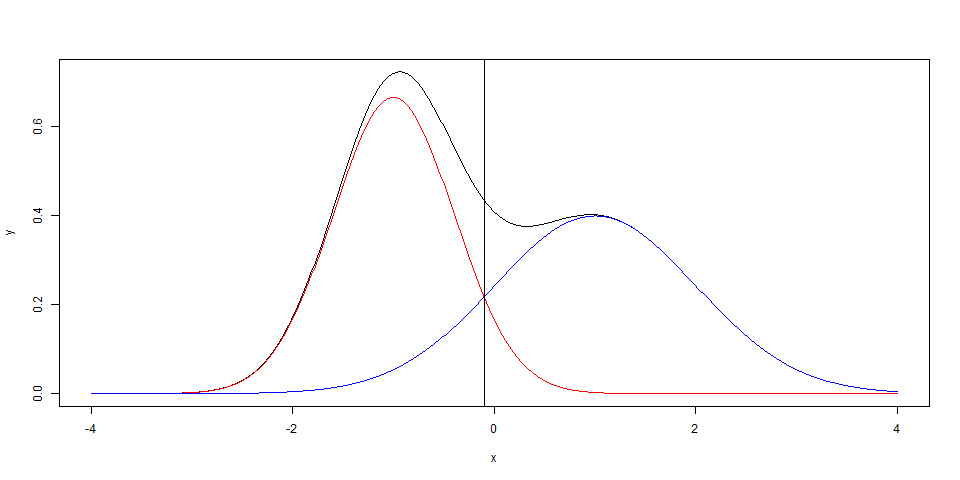

fk(x)=P(X∣Y=k)=(2π)p/2∣Σk∣1/21exp[−21(x−μk)TΣk−1(x−μk)]模型在此分成兩種,若假設

- Σk 相同,則此分類問題稱為 linear discriminant analysis (LDA)

- Σk 不同,則此分類問題稱為 quadratic discriminant analysis (QDA)

Base Line Method

以第 K 項作為 base line,比較在給定 x 時,Y 為何類的機率最高

G(x)=k∈YargmaxP(X=x∣Y=k)P(Y=k)=k∈Yargmaxln[P(Y=K∣X=x)P(Y=k∣X=x)]=k∈Yargmaxln(fK(x)fk(x))+ln(πKπk)會選擇將兩項對除的理由是,能消除常數項;取 ln 的理由是,且此機率有關 normal 分布,能與 exp 對消。

Linear Discriminant Analysis (LDA)

假設 Σk=Σ 全部相同

=ln(fK(x)fk(x))+ln(πKπk) xTΣ−1(μk−μK)−21(μk+μK)TΣ−1(μk−μK)其中的 K 有關次項在 G(x) 最大化的目標 argmaxk∈Y 不起作用,因此等價於

G(x)=k∈Yargmaxln(fK(x)fk(x))+ln(πKπk)=k∈YargmaxxTΣ−1μk−21μkTΣ−1μk+ln(πk)設其中的

δk(x)=xTΣ−1μk−21μkTΣ−1μk+ln(πk)因此 G(x)=argmaxk∈Yδk(x)。其中有數個參數需要估計

- μ^k=nk/n,其中 nK 是第 k 類的數量,n 是樣本總數

- μ^k=∑yi=kxi/nk

- Σ^=∑k=1K∑yi=k(xi−μ^k)(xi−μ^k)T/(n−K)

Auadratic Discriminant Analysis (QDA)

假設 Σk 是不同的,使得 base line 函式寫成

δk(x)=−21(x−μk)TΣk−1(x−μk)−21ln∣Σk−1∣+ln(πk)其中的

Σ^k=nk1yi=k∑(xi−μ^k)(xi−μ^k)TLDA vs QDA

這討論這兩個模型的好壞前,先了解到 LDA 與 QDA 並沒有 nested 的關係,例如線性回歸的 f1(x)=β0+β1x 與 f2(x)=β0+β1x+β2x2,可以透過 H:β2=0 的假設檢定,若 β2 顯著為 0 則 f2 會退化成 f1,因此稱為 nested。由於 LDA 與 QDA 並不 nested,因此建議是兩種模型均嘗試。

若 x∈Rp,則 LDA 需要估計 μ1,μ2,⋯,μK 與 Σ,大致上需要估計 Kp+p2 個參數;相對於 QDA 需要估計更多 Σ1,Σ2,⋯,ΣK,大致上需要估計 K(p2+p) 個參數,眾多參數量使得 QDA 在小樣本,多分類情況下表現並不一定理想。

參數假設

QDA 假設每個群組都有不同的 Σk,雖然能更適用範圍更大,但複雜模型有太多參數需要估計,有時用更強的假設會得到更好的結果。

Normal

若 X 的分布並非常態分布,可以考慮

- 降低維度

- 轉換 (ex: x1/2、ln(x))

Variance-Covariance

- 假設 Σk=Σ 都相同,即用 LDA 取代 QDA

- Independent: 假設 Σ=diag(σ12,σ22,⋯,σp2)

- Common variance: 假設 Σ=σ2Ip×p

參考資料